导读:NLP领域著名学者,斯坦福大学教授克里斯托弗 · 曼宁(Christopher Manning)在美国人文与科学学院(AAAS)期刊的 AI & Society 特刊上发表了题为《Human Language Understanding & Reasoning》的文章。从NLP学界、业界的现实出发,回顾了NLP语言模型的发展历史,展望大型语言模型的发展趋势,并对语言模型理解人类语言的本质做了哲学层面的探讨。NLP语言模型是否在向认知智能的“奇点”邻近,让我们循着大师的理解来一探究竟。

翻译:达观数据解决方案副总监 高长宽

Abstract:在过去的十年里,通过使用简单的人工神经网络计算,基于以GPU、TPU为代表的强大算力资源,并在巨量的数据上进行训练,自然语言处理取得了令世人瞩目的成就和突破。由此产生的预训练语言模型,如BERT和GPT-3,提供了一个强大的通用语言理解和生成基础(A Powerful Universal Language Understanding and Generation Base),它们可以很容易地迁移到许多语义理解、智能写作和推理任务当中。这些模型显示了一种更普遍的人工智能形式的雏形,这可能会导致在语言以外的感官经验领域产生强大的基础模型(Foundation Models)。

当科学家们考虑人工智能时,他们大多想到的是对个体人脑的能力进行建模或再造。但是,现代人类的智能远远超出了个体大脑的智能。人类的语言是强大的,对我们这个物种来说是变革性的,它不仅是人类区别于其他动物的最显著的特征,更因为它提供给人类一种将众多个体大脑“联网”的方法。人类个体可能并不比我们的近亲黑猩猩或倭黑猩猩的智力高多少。这些猿猴已被证明拥有许多人类智能的标志性技能,诸如使用工具、做计划和在族群中获取权力。此外,它们的短期记忆比我们更好。

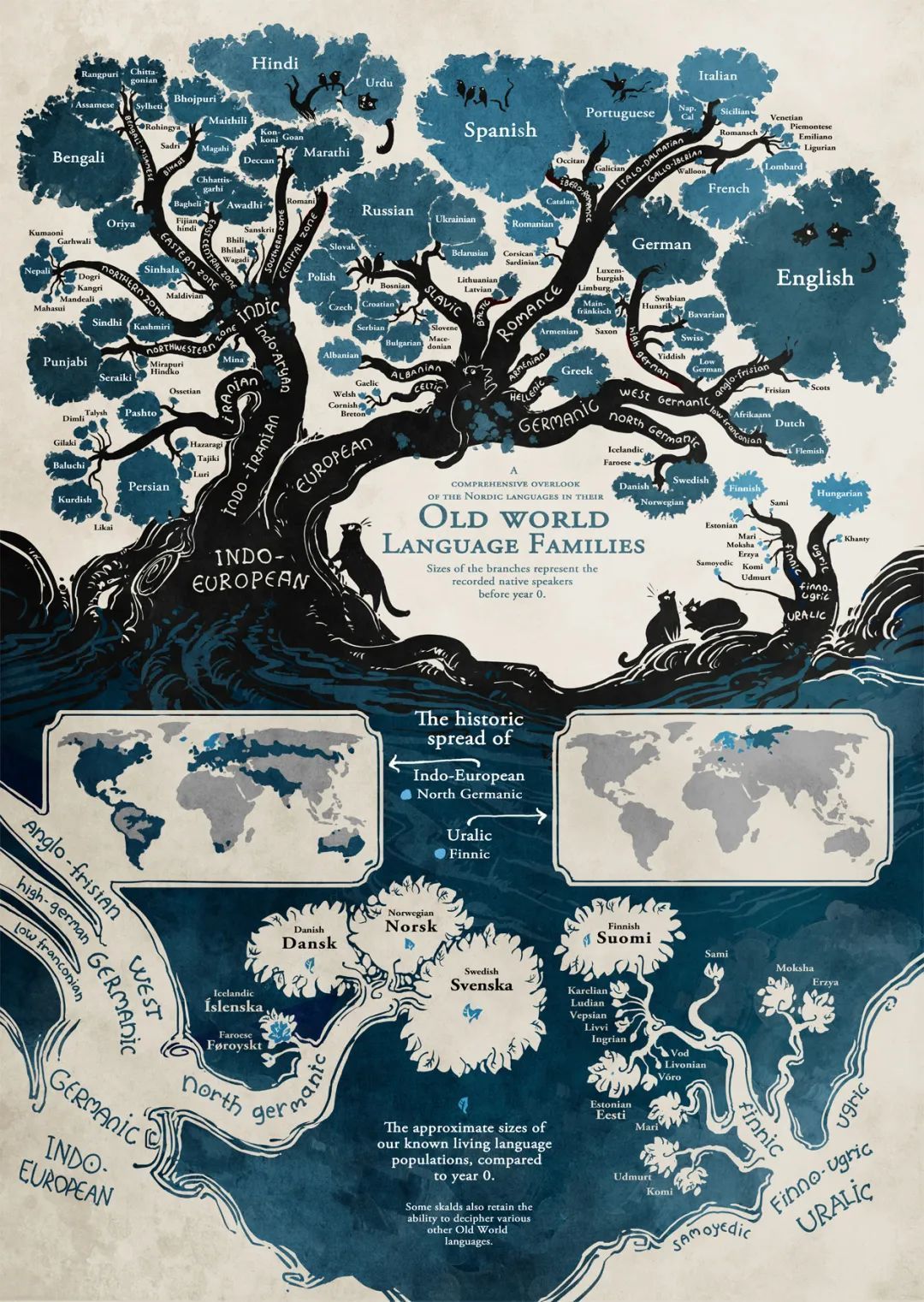

直到现在,人类发明语言的时间仍然是不确定的,也许永远都是不确定的,但是在地球生命漫长的进化史中,人类只是在最近很短的时间内不可思议地发展出了语言。原生动物、猴子和猿类的共同祖先可以追溯到6500万年前;人类从黑猩猩中分离出来可能是600万年前,而人类的语言一般被认为只有几十万年的历史。尽管我们不像大象那样强壮,也不像猎豹那样快,然而,一旦人类发展出了语言,交流、沟通的力量会迅速导致智人超越其他生物。最近几十万年,人类才发展出文字(仅在五千多年前),并逐渐拥有了建构复杂句子的能力,使得知识能够在不同的时间和空间的进行流转。在短短的几千年里,这种信息共享机制把我们从悠远的青铜时代带到了现今的智能手机时代。一个高保真编码既允许人类之间的理性讨论,也允许信息的传播,这使得复杂社会的文化演变和现代技术知识积累成为可能。语言的力量是人类社会智能的根本,在人类能力被人工智能工具逐步增强的未来世界中,语言仍将保持重要的作用。

鉴于上述原因,自然语言处理(NLP)领域是人工智能的最早的热门研究方向之一。事实上,关于机器翻译这类NLP问题的最初工作,包括1954年著名的Georgetown-IBM演示,甚至略早于1956年 “人工智能 “一词的诞生。然后,我描述了最近NLP的戏剧性发展,这些发展源自对大量数据进行训练的大型人工神经网络模型的使用。我追溯了在使用这些技术建立有效的NLP系统方面所取得的巨大进展,并在最后对这些模型所取得的成就和该领域下一步的发展方向提出了自己的一些想法。

到目前为止,自然语言处理的历史可以大致分为四个阶段。

第一个阶段,是从1950年开始再到1969年结束。NLP研究肇始于对机器翻译的研究。人们想象,翻译可以迅速建立在计算机在二战期间破译密码的巨大成功之上。冷战时期,美苏两方的研究人员都试图开发能够翻译其他国家的科学成果的系统。然而,在这个时代的开始,人们对人类语言的结构、人工智能或机器学习几乎一无所知。现在回想起来,当时可用的算力和数据规模小得可怜。虽然最初的系统被大张旗鼓地推广,但这些系统只提供了单词级的翻译查找和一些简单的、不是很有原则的基于规则的机制来处理单词的屈折形式(词法)和词序。

第二个阶段,是从1970年到1992年,这段时间开发了一系列的NLP示范系统,在处理人类语言中的句法和参照物等现象方面表现出复杂性和深度。这些系统包括Terry Winograd的SHRDLU,Bill Woods的LUNAR,Roger Schank的SAM等系统,Gary Hendrix的LIFER,以及Danny Bobrow的GUS。

语言学和基于知识的人工智能发展迅猛,在这个时代的第二个十年,新一代的手工构建(Hand-Built)的系统出现了,它们在陈述性语言知识和程序性处理之间有了明确的分离,并且受益于一系列更现代的语言学理论的发展。

然而,NLP的工作方向在第三个阶段发生了显著的变化,大约是在1993年~2012年期间。在这一时期,数字化的文本数据大量出现,引人注目的方向是开发能够在大量自然文本上实现某种程度的语言理解(Language Understanding)的算法,并利用这些文本的存在来帮助提供这种能力。这导致该领域围绕NLP的经验性机器学习模型进行了根本性的重新定位,也就是从规则转向统计,这一方向至今仍主导着该领域。在这一时期的开始,主流的操作方式是掌握可观数量的在线文本–在那些日子里,文本数据集一般都在几千万字以下–并从这些数据中提取某种模型,主要是通过计算特定的事实。例如,你可能会了解到,人们捕捉到的事物种类在有人的地点(如城市、城镇或堡垒)和隐喻性概念(如想象力、注意力或本质)之间相当均衡。但是,在提供语言理解能力方面,对词汇的计数只能走到这一步,早期从文本集合中学习语言结构的经验性尝试相当不成功。这导致该领域的大多数人集中于构建基于人工标注的语言资源,比如标注词语在某一场景下特定含义、文本中人名或公司名称的实例,或treebank中句子的语法结构,然后使用有监督机器学习技术来构建模型,在运行时对新的文本片段产生类似的标签。

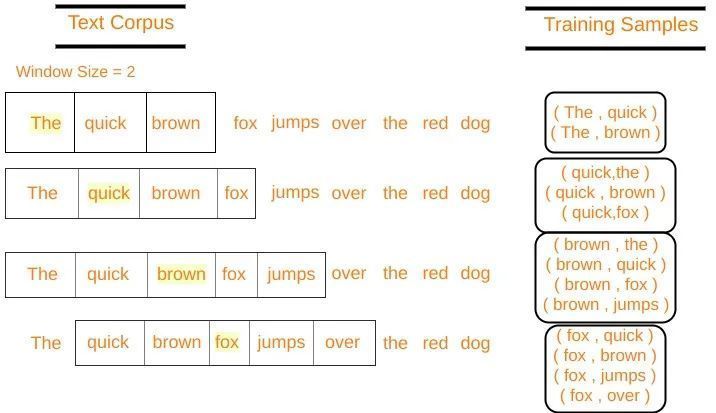

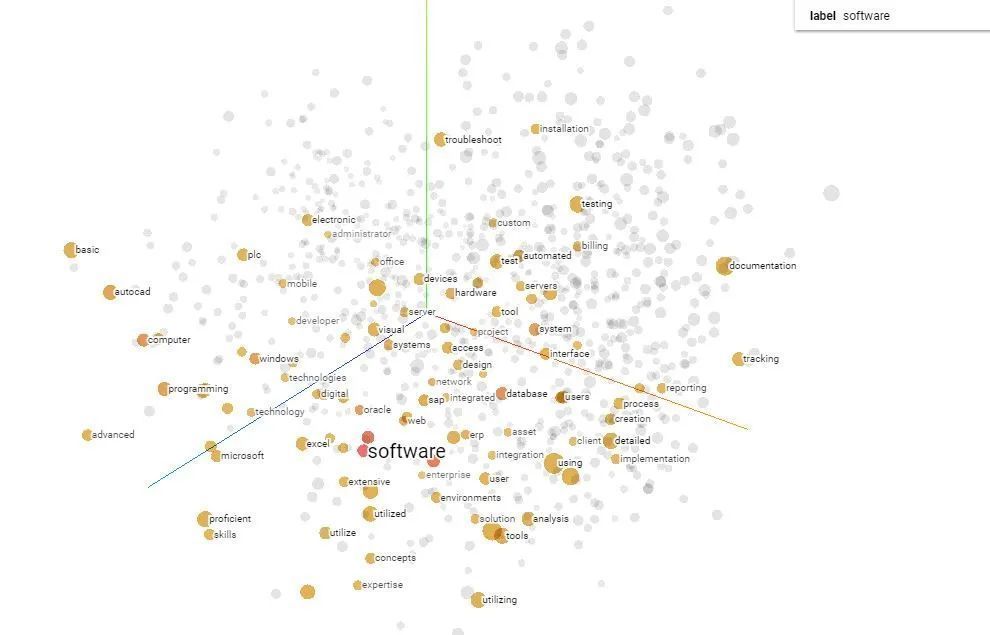

2013年至今延续了第三个阶段的经验取向,但由于引入了深度学习或人工神经网络方法,这项工作发生了巨大的变化。在这种方法中,词汇和句子的语义通过在一个(几百或一千维)实数向量空间中的位置来表示,而意义或句法的相似性则通过在这个空间中的接近程度(距离远近)来表示。从2013年到2018年,深度学习为建立高性能的模型提供了更强大的基线方案:更容易对较长距离的语境进行建模,而且模型对具有相似含义的词汇或短语的泛化性更好,因为它们可以利用向量空间中的接近性,而不是取决于符号层面的相似性(比如两个词汇在词形方面很接近,但意义无关甚至相反)。尽管如此,在建立有监督的机器学习模型以执行特定的分析任务方面,这种方法是不变的。

word2vec模型训练原理示例

经word2vec训练后,得到的词汇表示在语义空间可以进行加减乘除等数学运算

然而,一切都在2018年10月份之后发生了变化 — 当时NLP是非常大规模的自监督神经网络学习的第一次重大成功。在这种方法中,模型只需接收到极大量(20GB起步)的文本(现在通常是几十亿字),就能学习到大量关于语言和现实世界的大部分知识。做到这一点,得益于transformer系模型强大的自监督学习方式:模型从文本中自动创建能挑战自己的预测任务—类似“完形填空”,例如, 例如在给定先前词汇的情况下依次识别文本中的每个下一个单词,或在文本中填写一个被遮掩的词汇或短语。通过数十次重复这样的预测任务,并从错误中学习,所以模型在下一次给定类似的文本上下文语境时做得更好,由此关于语言和现实世界的一般知识被积累起来,然后这些知识可以被应用到下游的语义理解任务中,比如文本分类、文本检索、情绪分析或阅读理解。

事后看来,大规模自监督学习方法(Large-Scale Self-Supervised Learning Approaches)的发展很可能被视为根本性的变化,而第三个阶段2017年戛然而止。基于自监督的预训练方法的影响是革命性的:现在有可能在大量未标记的人类语言材料上训练模型,从而产生一个大型的预训练模型,通过微调(Fine-Tuning)或提示(Prompting),可以轻而易举的在各种自然语言理解和生成任务取得较好的结果。因此,NLP的进展和兴趣已经爆炸性增长。 乐观一些的看法是,具有一定程度通用智能的蕴含海量知识的系统(Knowledge-Imbued Systems)正逐渐涌现。

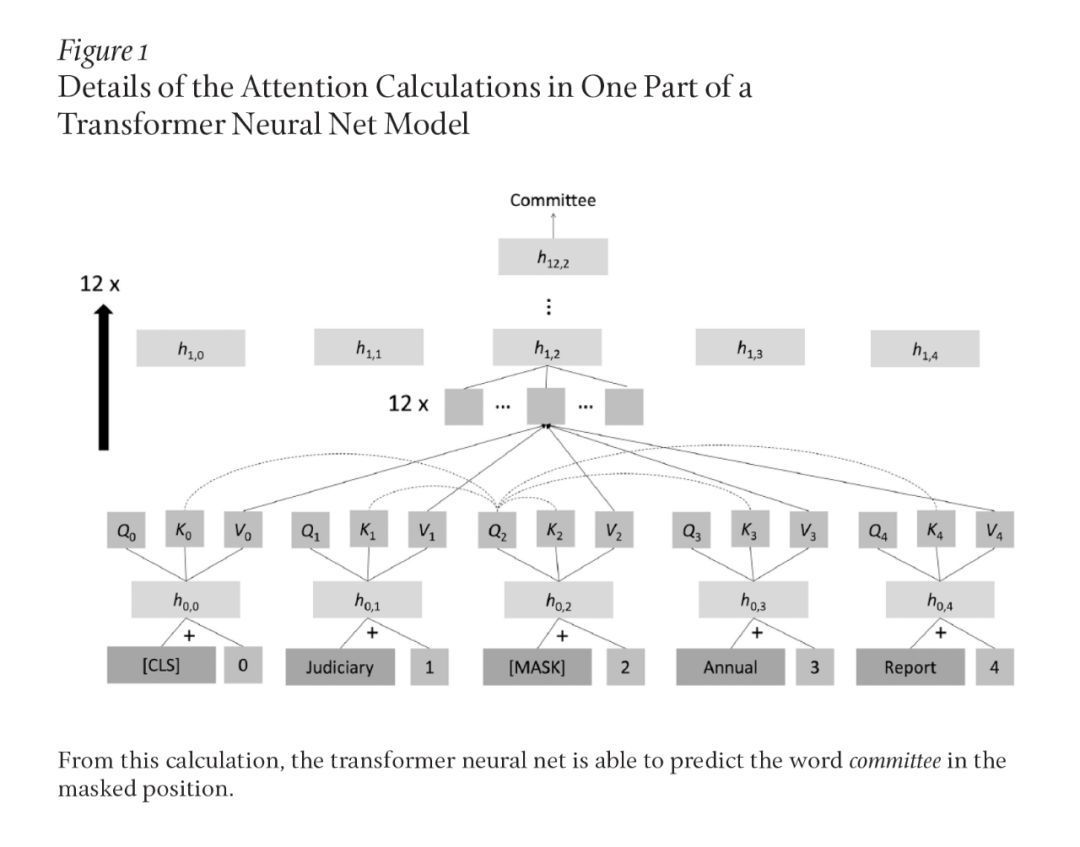

我不能在这里对现在占主导地位深度学习预训练模型进行全面描述,因为18年~22年期间诞生的此类模型及其变种实在是太多了,但我可以提供一个线索。这些模型通过实数向量来表示一切,并且能够在接触到许多文本数据后,通过误差的反向传播(归结为做微分计算)从一些预测任务回到文本中的词的表示,从而学习到较好的语义表示。自2018年以来,NLP应用的主流模型一直是transformer系的神经网络。transformer是一个比早几十年探索的简单的词汇序列神经网络复杂得多的模型。其主导思想是attention(注意力机制),通过这种思想,一个位置的表征被计算为其他位置的表征的加权组合。transformer模型中一个常见的自监督目标是遮掩文本中的偶发词(Occasional Words)。该模型会计算出曾经出现过的词汇。它通过从每个词的位置(包括遮蔽位置)计算出代表该位置的查询、键和值的向量来实现这一目标。将某个位置的查询与每个位置的值进行比较,以计算出对每个位置的关注程度;在此基础上,计算出所有位置的值的加权平均值。这个操作在transformer神经网的每一层都要重复多次,所得的值通过全连接神经网层并通过使用归一化层和残差连接进一步处理,为每个词产生一个新的向量。整个过程重复多次,给transformer神经网带来额外的深度层。最后,掩码位置上方的表示应该捕捉到原始文本中存在的词汇。例如,如图1所示的committee:

通过transformer深度神经网络的诸多简单计算可以实现或学习什么,这一点很难直观了解到。起初,这可能听起来像是某种复杂的统计关联学习器(Statistical Association Learner)。然而,考虑到像transformer这样一个非常强大的、灵活的、高参数的模型和海量的文本数据来学习和预测,这些模型发现并表征了人类语言的大部分结构。事实上,很多研究表明,这些模型学习并表征了语句的句法结构,并将学习、记忆现实世界中的许多事实,因为这些东西都有助于模型成功地预测遮蔽词(Masked Words)。此外,虽然预测一个被遮掩的词最初看起来是一个相当简单和低层次的任务–一种无幽默感的 “疯狂的自由”,而并不是什么复杂的任务,如用图示显示一个句子的语法结构,但这项任务被证明是非常强大的,因为它是普遍的:每一种形式的语言和世界知识,从句子结构、词的内涵和关于现实世界的事实,帮助人们更好地完成这一任务。因此,这些模型集合了它们所接触的语言和现实世界的大量一般知识。一个这样的大型预训练语言模型(LPLM)可以被应用到许多特定的NLP任务中,只需要少量的训练数据做进一步“指导”。从2018年到2020年,这样做的标准方式是通过少量的额外有监督学习对模型进行微调,对感兴趣的特定任务(如情绪分析、阅读理解和实体抽取)进行训练。但是最近,研究人员出人意料地发现,这些模型中最大的模型,如GPT-3(Generative Pre-trained Transformer-3),只需一个提示(Prompt)就可以很好地完成新的任务。给他们一个人类语言描述或几个希望他们做什么的例子,他们就能完成许多他们从未接受过训练的任务。

传统的自然语言处理模型是由几个通常独立开发的组件精心“拼装”而成的,经常被构建成一个流水线(Pipeline),它首先捕捉文本的句子结构和低层次的实体,然后再理解一些高层次的语义信息,并将其输入一些特定领域的执行组件。在过去的几年里,各公司已经开始用LPLM来取代这种传统的NLP解决方案,通常会对其进行微调以执行特定的任务。我们可以期待这些系统在2020年代做什么?早期的机器翻译系统涵盖了有限领域的有限语言结构。基于平行翻译语料库建立大型统计模型,使得具有较强泛化能力的机器翻译成为可能,这是大多数人在2006年谷歌翻译推出后首次体验的东西。十年后的2016年底,当谷歌转向使用神经机器翻译时,谷歌的机器翻译有了明显的改善。但该系统的寿命较短:基于transformer的神经网络翻译在2020年推出。这个新系统不仅通过不同的神经架构,而且使用与以往网络结构截然不同的模型进行优化。新系统不是从平行文本中建立双语匹配,从而在两种语言之间进行翻译,而是从一个巨大的神经网络中获益,该网络同时对谷歌翻译所涵盖的所有语言进行训练,只需用一个明显的标记(target_language、source_language)来表示语言。虽然这个系统仍然会犯错,机器翻译的研究也在继续,但今天自动翻译的质量是非常出色的。当我从今天的《世界报》文化版中输入几个句子:

Il avait été surnommé, au milieu des années 1930, le « Fou chantant », alors qu’il faisait ses débuts d’artiste soliste après avoir créé, en 1933, un duo à succès avec le pianiste Johnny Hess. Pour son dynamisme sur scène, silhouette agile, ses yeux écarquillés et rieurs, ses cheveux en bataille, surtout pour le rythme qu’il donnait aux mots dans ses interprétations et l’écriture de ses textes.(20世纪30年代中期,他在1933年与钢琴家约翰尼-赫斯成功创作了一首二重奏后,首次以独唱艺术家的身份亮相,被人称为 “唱歌的傻瓜”。他以充满活力的舞台形象、敏捷的身手、宽大的笑眼、狂野的头发而闻名,最重要的是他在演绎和撰写歌词时赋予文字以节奏。)

由机器出的译文质量较高:

He was nicknamed the Singing Madman in the mid-1930s when he was making his debut as a solo artist after creating a successful duet with pianist Johnny Hess in 1933. For his dynamism on stage, his agile figure, his wide, laughing eyes, his messy hair, especially for the rhythm he gave to the words in his interpretations and the writing of his texts.

在智能问答中,一个系统在一系列文本中寻找相关的信息,然后为特定的问题提供答案(是一个片段,而不是像早期的网络搜索那样,只返回被认为包含相关信息的页面)。智能问答有许多直接的商业应用,包括售前和售后客户支持。现代神经网络问题回答系统在提取文本中的答案方面有很高的准确性,甚至在找出没有答案的情况下也相当出色。例如,从这段话中可以看出:

三星为Galaxy Note 20 Ultra保留了最好的功能,包括比Galaxy S20 Ultra更精致的设计–我不推荐这款手机。你会发现一个特殊的6.9英寸屏幕,锐利的5倍光学变焦相机和一个更迅速的手写笔,用于注释屏幕截图和做笔记。与Note 10 Plus相比,Note 20 Ultra还做了一些小而重要的改进,特别是在相机领域。这些功能是否证明了Note 20 Ultra的价格合理?128GB版本的起价为1300美元。这个零售价是一个很高的要求,特别是当你结合全球经济深度衰退和失业率上升的环境时。

人们可以得到如下问题的答案,答案是从上面大段文字中抽取的片段,很精确:

三星Galaxy Note 20 Ultra的价格是多少?

128GB版本为1300美元

Galaxy Note 20 Ultra有20倍光学变焦吗?

没有

Galaxy Note 20 Ultra的光学变焦是多少?

5x

Galaxy Note 20 Ultra的屏幕有多大?

6.9英寸

对于常见的传统NLP任务,如在一段文本中找出人名或组织名称,或对关于产品的文本进行情感分类(积极或消极),目前最好的系统还是基于LPLMs,一般通过提供一些训练数据进行微调。虽然这些任务即使在最近的大型语言模型之前也可以做得很好,但这些模型中蕴藏了海量关于语言和现实世界的更广泛知识,从而进一步提高了这些任务的性能。

最后,LPLMs还具有生成流畅、连贯且内在语义一致的文本的能力。除了许多创造性的用途外,这种系统还有平淡无奇的用途,从编写“程式化”的新闻文章,如天气预报、体育报道,到自动总结。例如,这样的系统可以帮助放射科医生,根据放射科医生的发现来输出诊断摘要。对于下面的研究结果,我们可以看到,系统生成的摘要与放射科医生自己撰写的总结非常相似:

发现:管线/管子:右髂骨鞘,中心静脉导管尖端在最初的X光片上,气管导管在锁骨头之间,肠管的侧口在ge交界处,尖端在视场外的横膈膜下;这些在随后的胶片上被移除。纵隔引流管和左胸造口管没有变化。肺部:肺容积较小。心后空隙疾病,在最近的片子中略有增加。胸膜:左胸腔少量积液。没有气胸。心脏和纵隔:手术后心脏纵隔轮廓变宽。主动脉弓钙化。骨骼:完整的胸骨正中切口线。

放射科医生生成的印象:左侧基底空隙病变和左侧小量胸腔积液。线条和管道位置如上。

系统自动生成的摘要:线条和管子的位置如上所述。心后空隙疾病,在最近的片子上略有增加。左侧小胸腔积液。

最近,这些NLP系统在许多任务上表现得非常好。事实上,给定一个较为明确的NLU任务,它们往往可以被“调教”得和人类的表现一样好。然而,我们仍然有理由怀疑这些系统是不是真的理解它们在做什么,或者它们是否只是“精心设计”的改写系统,而不是真正意义上的理解语义。

不仅在语言学和语言哲学中,而且在编程语言中,描述意义的主流方法是指称语义学方法或指称理论:一个词、短语或句子的意义是它所描述的世界上的一组对象或情况(或其数学抽象)。这与NLP中现代经验性工作的简单的分布式语义学(Distributional Semantics)形成了对比,根据后者,一个词的意义只是对它出现的上下文语境的描述。意义不是全有或全无;在许多情况下,我们只能在部分的理解语言形式(Linguistic Form)的意义。我认为,意义产生于对语言形式与其他事物之间的联系网络的理解,无论是世界上的物体还是其他语言形式。如果我们拥有一个密集的连接网络,那么我们就对语言形式的意义有一个很好的感知。例如,如果我接触过印度的舍尼琴(shehnai),那么我对这个词的意义就有一个较为合理的概念,跟进一步,如果我还听过舍尼琴的演奏曲,那么“舍尼琴”将会在我的心目中有着更为丰富的内涵。反过来说,如果我从来没有见过、摸过或听过舍奈琴,但有人告诉我它就像传统的印度双簧管,那么这个词对我来说就有一些“较浅”的意义:它与印度、与使用簧片的管乐器、与演奏音乐有联系。如果有人补充说,它的孔有点像直笛,但它有多个簧片和一个外翻的末端,更像双簧管,那么我就有更多的舍尼琴的物品属性知识。相反,我可能没有这些信息,而只是有一些包含“舍尼琴”的语句,比如说,“从一周前开始,舍尼琴的演奏者就坐在房子门口的竹制马车里,吹着他们的管子”、“Bikash Babu不喜欢舍尼琴的哭声,但他决心满足新郎家可能有的所有传统期望”。那么,在某些方面,我会对“舍尼琴”这个词的内涵理解得比较少,但我仍然知道它是一种“管状的乐器”,我对“舍尼琴”的了解并不是那些仅仅拿过舍尼琴的人的理解的子集,因为我知道这个词所关联的某些文化联系,而他们是不了解的,只知道是个能吹的乐器。

使用这个定义,即理解意义(Understanding Meaning)包括理解语言形式的连接网络,毫无疑问,诸如BERT这类预训练语言模型会学习意义。除了词汇本身的意义之外,这些模型还学习了很多关于现实世界的知识。如果它们在维基百科的文本上接受训练(正如它们通常所做的那样),它们就会了解到亚伯拉罕-林肯于1809年出生在肯塔基州,以及“命运之子(Destiny’s Child)”的主唱是碧昂斯-诺尔斯-卡特。机器可以像人一样,从作为人类知识仓库的书写文本中受益匪浅。然而,模型所学习到的词义和世界知识往往是非常不完整的,需要用其他的感官数据和知识来补充(比如是图像、声音和结构化的知识图谱)。

LPLMs在语言理解任务上的成功,以及将大规模自监督学习扩展到其他类型的数据上–如视觉、机器人、知识图谱、生物信息学和多模态数据(Multimodal Data)的激动人心的前景,表明我们正在探索一个更具普适性的方向。我们提出了基础模型(Foundation Models)这一术语,是指在大量数据上通过自监督模式训练出的具有数百万级规模参数的通用模型,它们可以很容易地在许多下游任务上进行微调并做出合理的预测。其中,一个方向是将语言模型与更多的结构化的知识库连接起来,这些知识库以知识图谱神经网络的形式表示,或者以大量文本的形式提供,以便在运行时进行“查阅”。这方面的一个例子是最近的DALL-E模型,在对海量的图像-文本数据进行自监督学习后,可以通过输入一段文字产生栩栩如生、颗粒度极为精细的图像。

我们仍然处于基础模型(Foundation Models)时代的早期,但让我勾勒出一个可能的未来。大多数信息处理和分析任务,甚至像机器人控制这样的事情,都将由相对较少的基础模型中的一个专门化来处理。这些模型的训练将是昂贵和耗时的,但使它们适应不同的任务将是相当容易的;事实上,人们可能只需用自然语言指令就能做到。由此产生的对少数模型的趋同带来了一些风险:有能力建立这些模型的团体可能有过度的权力和影响,许多终端用户可能会受到这些模型中存在的任何偏见的影响,而且由于模型和它们的训练数据是如此之大,将很难判断模型在特定情况下是否可以安全使用。尽管如此,这些模型将从大量训练数据中获得的知识部署到许多不同的运行时任务的能力将使这些模型变得强大,它们将首次展示人工智能的目标,即一个机器学习模型根据简单的现场指示完成许多特定的任务。虽然对这些模型的最终可能性只有朦胧的了解,但它们可能仍然是有限的,缺乏人类水平的仔细逻辑或因果推理的能力。但基础模型的广泛有效性意味着它们将被非常广泛地部署,并且它们将在未来十年为人们提供更普遍形式的人工智能的第一瞥。

原文标题:Human Language Understanding & Reasoning

原文作者:Christopher D. Manning,现任斯坦福大学教授、斯坦福自然语言处理组负责人。Christopher Manning是自然语言处理领域著名学者,是国际计算机学会(ACM)、国际人工智协会(AAAI)、国际计算语言学会(ACL)等国际权威学术组织的会士,曾获ACL、EMNLP、COLING、CHI等国际顶会最佳论文奖,著有《统计自然语言处理基础》、《信息检索导论》等自然语言处理著名教材。

原文地址:1.https://www.amacad.org/sites/default/files/publication/downloads/Daedalus_Sp22_09_Manning.pdf

2.American Academy of Arts and Sciences (amacad.org)

Endnotes

- 1、Frans de Waal, Are We Smart Enough to Know How Smart Animals Are? (New York: W. W. Norton, 2017).

- 2、Mark Pagel, “Q&A: What Is Human Language, When Did It Evolve and Why Should We Care?” BMC Biology 15 (1) (2017): 64.

- 3、W. John Hutchins, “The Georgetown-IBM Experiment Demonstrated in January 1954,” in Machine Translation: From Real Users to Research, ed. Robert E. Frederking and Kathryn B. Taylor (New York: Springer, 2004), 102–114.

- 4、A survey of these systems and references to individual systems appears in Avron Barr, “Natural Language Understanding,” AI Magazine, Fall 1980.

- 5、Larry R. Harris, “Experience with Robot in 12 Commercial, Natural Language Data Base Query Applications” in Proceedings of the 6th International Joint Conference on Artificial Intelligence, IJCAI-79 (Santa Clara, Calif.: International Joint Conferences on Artificial Intelligence Organization, 1979), 365–371.

- 6、Glenn Carroll and Eugene Charniak, “Two Experiments on Learning Probabilistic Dependency Grammars from Corpora,” in Working Notes of the Workshop Statistically-Based NLP Techniques, ed. Carl Weir, Stephen Abney, Ralph Grishman, and Ralph Weischedel (Menlo Park, Calif.: AAAI Press, 1992).

- 7、Ashish Vaswani, Noam Shazeer, Niki Parmar, et al., “Attention Is All You Need,” Advances in Neural Information Processing Systems 30 (2017).

- 8、Christopher D. Manning, Kevin Clark, John Hewitt, et al., “Emergent Linguistic Structure in Artificial Neural Networks Trained by Self-Supervision,” Proceedings of the National Academy of Sciences 117 (48) (2020): 30046–30054.

- 9、Tom Brown, Benjamin Mann, Nick Ryder, et al., “Language Models Are Few-Shot Learners,” Advances in Neural Information Processing Systems 33 (2020): 1877–1901.

- 10、For example, Météo translated Canadian weather reports between French and English; see Monique Chevalier, Jules Dansereau, and Guy Poulin, TAUM-MÉTÉO: Description du système (Montreal: Traduction Automatique à l’Université de Montréal, 1978).

- 11、Gideon Lewis-Kraus, “The Great A.I. Awakening,” The New York Times Magazine, December 18, 2016.

- 12、Isaac Caswell and Bowen Liang, “Recent Advances in Google Translate,” Google AI Blog, June 8, 2020

- 13、Sylvain Siclier, “A Paris, le Hall de la chanson fête les inventions de Charles Trenet,” Le Monde, June 16, 2021.

- 14、Daniel Khashabi, Sewon Min, Tushar Khot, et al., “UnifiedQA: Crossing Format Boundaries with a Single QA System,” in Findings of the Association for Computational Linguistics: EMNLP 2020 (Stroudsburg, Pa.: Association for Computational Linguistics, 2020), 1896–1907.

- 15、Yuhao Zhang, Derek Merck, Emily Bao Tsai, et al., “Optimizing the Factual Correctness of a Summary: A Study of Summarizing Radiology Reports,” in Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics (Stroudsburg, Pa.: Association for Computational Linguistics, 2020), 5108–5120.

- 16、For an introduction to this contrast, see Gemma Boleda and Aurélie Herbelot, “Formal Distributional Semantics: Introduction to the Special Issue,” Computational Linguistics 42 (4) (2016): 619–635.

- 17、Emily M. Bender and Alexander Koller, “Climbing towards NLU: On Meaning, Form, and Understanding in the Age of Data,” in Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics (Stroudsburg, Pa.: Association for Computational Linguistics, 2020), 5185–5198.

- 18、From Anuradha Roy, An Atlas of Impossible Longing (New York: Free Press, 2011).

- 19、Rishi Bommasani, Drew A. Hudson, Ehsan Adeli, et al., “On the Opportunities and Risks of Foundation Models,” arXiv (2021).

- 20、Jacob Devlin, Ming-Wei Chang, Kenton Lee, and Kristina Toutanova, “BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding,” in Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics (Stroudsburg, Pa.: Association for Computational Linguistics, 2019), 4171–4186.

- 21、Robert Logan, Nelson F. Liu, Matthew E. Peters, et al., “Barack’s Wife Hillary: Using Knowledge Graphs for Fact-Aware Language Modeling,” in Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics (Stroudsburg, Pa.: Association for Computational Linguistics, 2019), 5962–5971; and Kelvin Guu, Kenton Lee, Zora Tung, et al., “REALM: Retrieval-Augmented Language Model Pre-Training,” Proceedings of Machine Learning Research 119 (2020).

- 22、Aditya Ramesh, Mikhail Pavlov, Gabriel Goh, et al., “Zero-Shot Text-To-Image Generation,” arXiv (2021).